QuestMobile2024年AIGC应用发展年度报告数据显示,截至2024年12月,豆包App月活跃用户规模复合增长率达到21.2%,强势突破7500万大关,在综合类AI原生App中以显著优势稳居榜首。

在综合类原生App呈现的二八流量格局中,豆包与另外两家头部应用共同包揽80%流量,凭借庞大的用户基础和高活跃度,成为行业发展的引领者。

Doubao-1.5-pro-AS1-Preview模型能力更是炸裂,连网络梗知识都能给你分析得明明白白。

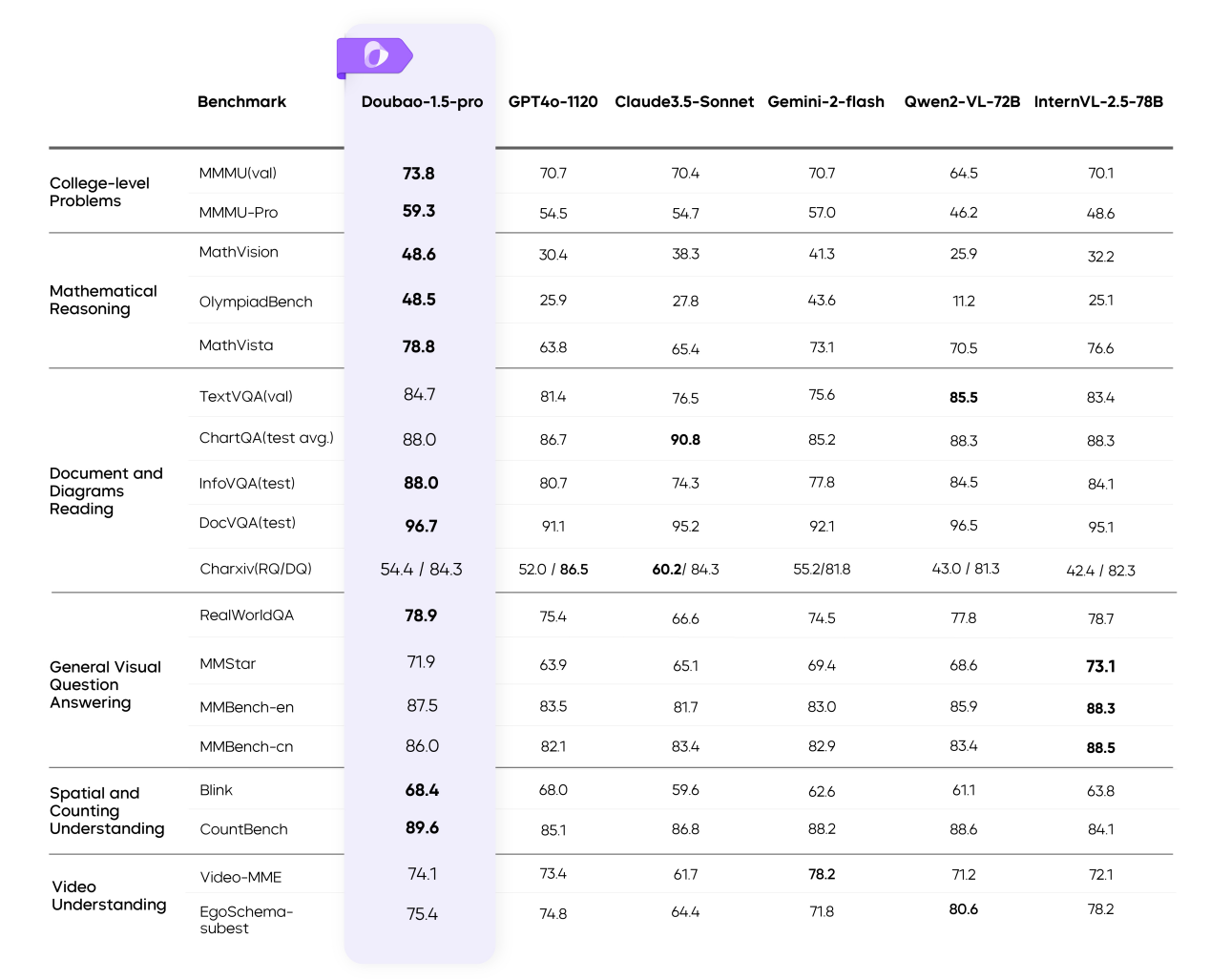

其次,视觉多模态性能进一步提升,从容应对更复杂场景。相比于上一版本,Doubao-1.5-pro在多模态数据合成、动态分辨率、多模态对齐、混合训练上进行了全面的技术提升,进一步增强了模型在视觉推理、文字文档识别、细粒度信息理解、指令遵循等方面的能力,并让模型的回复模式变得更加精简、友好。在同一模型中融入强大的视觉理解能力,使模型可以同时理解虚拟和现实世界的各类视觉信号,更好地辅助人类决策。输入任意分辨率图像,无论是高清大图、低分辨率小图还是极端长宽比图像。豆包大模型都能根据需求k8凯发,实现精准的特征提取和高效的计算性能,满足提问者对图像内容深度探索的需求。

笔者请求豆包批改图片中的英文作文,豆包很快就给出了评分与理由,并提出了修改意见。豆包对错误的识别异常精准,凯发k8娱乐官网app下载想来以后老师们改作业就有福了。

豆包最新更新的语音模式更是一绝。语音多模态理解生成一体化,情商智商双双在线。在语音多模态上,豆包团队提出了新的Speech2Speech的端到端框架,不仅通过原生方法将语音和文本模态进行深度融合,同时还实现了语音对话中真正意义上的语音理解生成端到端,相比传统的ASR+LLM+TTS的级联方式,在对话效果上有质的飞跃。这使得豆包语音模型可以理解各种人类情感,并完美的模仿出来。

而豆包走的是另外一条路。豆包1.5 pro的训练过程中完全依靠自有数据,不仅保障了数据的独立性和可靠性,还有效避免了外部模型潜在的偏差影响。

其次,豆包1.5 pro采用MoE(混合专家)架构,通过训练-推理一体化设计,在保持强大模型性能的同时,极大地降低了推理成本。

从训练和推理效率的角度来说,豆包1.5 pro所使用的稀疏MoE架构仅用较小参数激活,性能即可超过Llama3.1-405B等超大稠密预训练模型。

在完全相同的9T tokens数据对比验证下,用激活参数仅为稠密模型参数量1/7的MoE(混合专家)模型,就超过了稠密模型的性能。不仅如此,得益于更优的预训练数据质量和训练超参,Doubao-MoE的性能同样可以超越总参数远大于它的超大规模稠密预训练模型,比如LLaMA-3.1-405B,其训练数据为15T tokens。

另外,算法团队在预训练模型的基础上,设计了一系列模型参数动态调整算法,可以根据不同应用对模型性能的需求,从模型深度、宽度、MoE专家数、激活专家数、隐藏token推理等维度来选择扩增和缩小模型参数,灵活性和适配性拉满,最大程度达成模型能力与推理成本的最优平衡。

当下,人工智能已成为各行业转型升级的核心驱动力。豆包大模型凭借其卓越性能,在火山引擎的强力支撑下,正深度融入汽车、手机等诸多行业,重塑产业格局。

火山引擎作为字节跳动旗下云服务平台,帮助企业和开发者更方便地调用豆包大模型,大幅降低了使用成本,让企业能够以极低的成本获取强大的AI能力,真正实现了AI技术的普惠,为大中小企业在数字化转型过程中减轻了经济负担,加速了AI技术在各领域的广泛应用与深度融合。

据悉,豆包大模型已经与八成主流汽车品牌合作,并接入到荣耀、VIVO等多家手机品牌。此外,豆包视觉理解模型已经接入PC端产品。覆盖终端设备约3亿台,来自智能终端的豆包大模型调用量在半年时间内增长100倍。

火山引擎持续深耕技术研发,不断推动豆包大模型迭代升级。从豆包3D生成模型与火山引擎数字孪生平台veOmniverse协同打造物理世界仿真模拟器;到对标GPT-4o且价格优势显著的通用模型pro;再到音乐模型、文生图模型等功能的进阶突破,以及即将推出的视频生成模型1.5版和端到端实时语音模型所蕴含的巨大潜力,都彰显了其在AI领域的创新实力与全方位布局。在为企业提供丰富多样、高性能模型选择的同时,火山引擎还通过升级火山方舟、扣子和HiAgent等平台产品,助力企业高效构建自身AI能力中心,加速AI应用开发进程,全方位保障企业在智能化转型道路上稳步前行。

手机:13930752990

手机:13930752990  邮箱:admin@zwdzgs.com

邮箱:admin@zwdzgs.com  传真:13930752990

传真:13930752990  地址:河南省济源市梨林镇特色产业园

地址:河南省济源市梨林镇特色产业园